数据中心,如今正以前所未有的速度和规模,成为驱动全球经济和社会发展的核心引擎。如果说过去的PC、智能手机时代定义了半导体产业的黄金十年,那么以人工智能(AI)、云计算和超大规模基础设施为核心驱动力的数据中心,正在开启一个全新的“芯”纪元。

这不是一场渐进式的演变,而是一次颠覆性的变革。数据中心对芯片的需求,正从简单的处理器和内存,迅速演变为一个涵盖计算、存储、互连和供电等全方位的复杂生态系统。这股强大的需求浪潮,正在以前所未有的速度,将数据中心半导体市场推向一个万亿美元级的庞大体量。

AI狂潮:数据中心的“军备竞赛”

人工智能,特别是生成式AI的爆发,是这场变革最强大的催化剂。根据行业预测,AI相关的资本支出已经超越了非AI支出,占据了数据中心投资的近75%。到2025年,这一数字预计将超过4500亿美元。人工智能服务器正在快速增长,占计算服务器总量的比例已从 2020 年的几个百分点上升到 2024 年的 10% 以上。

在基础模型训练、推理和定制芯片创新的推动下,全球科技巨头正陷入一场激烈的“算力军备竞赛”。微软、谷歌、Meta等头部玩家每年投入数百亿美元,而中小企业也在快速跟进,因为他们深知,未来的竞争优势将直接取决于基础设施的规模和芯片级别的差异化。

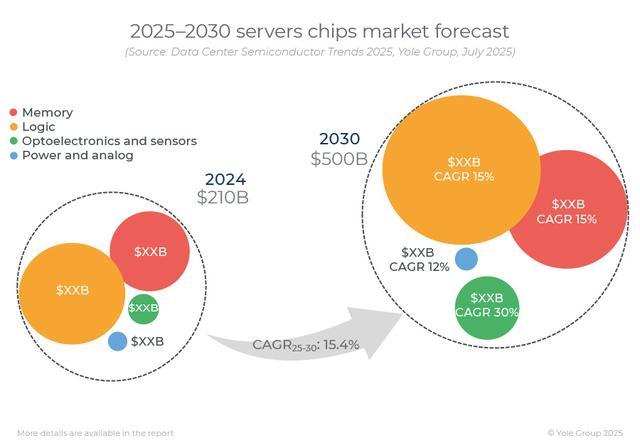

这种爆炸性的增长,正在催生出前所未有的半导体需求。Yole Group分析指出,数据中心半导体加速市场预计将在 2024 年开始扩张,到 2030 年预计将达到4930亿美元。届时,数据中心半导体预计将占整个半导体市场的 50% 以上,细分市场的复合年增长率(2025-2030 年)几乎是整个半导体行业的两倍,这反映了由人工智能、云计算和超大规模基础设施需求推动的巨大转变。

芯片们的狂欢

GPU与ASIC的竞速:首先,GPU无疑将继续占据主导地位,由于人工智能密集型工作负载的复杂性和处理需求不断增加,其增长速度最快。

NVIDIA凭借其强大的GPU生态系统,正在从一家传统芯片设计公司,蜕变为全栈式AI和数据中心解决方案提供商。其核心武器——Blackwell GPU凭借台积电4nm的先进工艺,继续在这一领域保持主导地位。

为了应对Nvidia的市场主导地位,大型云服务商如AWS、Google和Azure等,正在研发自有的AI加速芯片,如AWS的Graviton芯片,并在定制存储和网络硬件上进行创新。这些技术发展使得AI芯片领域的竞争愈发激烈,尤其是在推理和训练等环节,AI芯片的性能差异化将成为企业竞争的核心。

这种GPU与ASIC双线并行的局面,正在成为数据中心计算的主旋律。

HBM:随着AI模型规模的指数级增长,传统内存的带宽已经成为算力提升的最大瓶颈。高带宽内存(HBM)应运而生,凭借其创新的3D堆叠技术,极大地提升了内存带宽和容量,成为AI和高性能计算(HPC)服务器的“标配”。

根据Archive market research的研究报告,HBM市场正经历爆炸式增长,预计2025年将达到38.16亿美元,2025年至2033年复合年增长率(CAGR)高达68.2%。HBM的快速增长,正成为存储半导体市场的又一强劲增长点。

AI 芯片组的 HBM 市场呈现出几个关键趋势:首先,带宽和容量的趋势明显,单栈超过 8 GB 的模块越来越普遍,这源于日益复杂的 AI 模型对更快数据处理速度的迫切需求;其次,功耗效率是一个关键因素,推动了低功耗 HBM 设计的创新;第三,将 HBM直接集成到 AI 加速器上正变得越来越普遍,这最大限度地降低了延迟并提高了整体性能;第四,业界正在见证标准化接口的兴起,简化了系统集成并加快了 AI 系统的上市时间;第五,硅通孔 (TSV) 等先进封装技术的采用使得高密度、高效的 HBM 堆栈成为可能;最后,对边缘 AI 日益增长的需求正在推动针对嵌入式系统和移动设备等小型应用开发经济高效的 HBM 解决方案。

全球HBM市场的主要参与者主要包括SK海力士、三星、美光科技,国内也有几家厂商在做。其中,SK海力士和三星占据了全球HBM供应的90%以上。美光科技已成为首家量产HBM3E的美国公司,其产品已应用于英伟达的H200 GPU。

DPU与网络ASIC:在海量数据流动的AI时代,高效的网络互连至关重要。数据处理单元(DPU)和高性能网络ASIC的兴起,旨在分担CPU和GPU的网络处理任务,优化流量管理,从而释放出更多的计算资源。此外,在安全性、可扩展性、能效、长期的成本效益方面,DPU也具有很大的优势。

颠覆性技术:开启后摩尔时代新篇章

如果说AI是推动数据中心芯片需求量的核心,那么一系列颠覆性技术,则正在从底层架构上,重新定义数据中心的性能、效率和可持续性。

硅光子学与CPO:数据中心内部的数据传输,正在从传统的铜缆连接向光互连快速过渡。硅光子学(Silicon Photonics)技术,特别是共封装光学(CPO),正在成为解决高速、低功耗互连挑战的关键。CPO将光学引擎直接集成到CPU/GPU/ASIC等计算芯片的封装内部,极大地缩短了电气信号的传输路径,降低了延迟,并显著提高了能效。

Marvell、NVIDIA和博通等行业巨头正在积极布局,预计到2030年,该领域将创造数十亿美元的营收。今年1月份,Marvell宣布推出用于定制AI加速器的突破性共封装光学架构。集成共封装光学器件 (CPO) 的XPU通过将 XPU 密度从机架内的数十个增加到多个机架上的数百个,增强了 AI 服务器性能。

薄膜铌酸锂(TFLN)调制器是光通信领域的另一项突破性进展,它将高速铌酸锂调制器技术与硅光子学的可扩展性相结合。TFLN调制器具有超高带宽(>70GHz)、极低的插入损耗(

CPO直接解决了限制可插拔解决方案的“电接口瓶颈”,从而在功率和带宽方面实现了关键性飞跃 。这可以看作是继“内存墙”之后,对“电墙”的突破,对于应对日益增长的功率密度以及数据中心内部和之间更高效的数据传输至关重要。CPO能够实现更长距离和更高密度的XPU到XPU连接,这促进了数据中心架构的进一步解耦,使得计算资源能够更灵活地分布 。

先进封装:CPO只是先进封装技术在数据中心应用的一个缩影。通过3D堆叠、小芯片(Chiplet)等技术,半导体制造商可以将不同功能的芯片(如计算、内存、I/O等)集成在同一基板上,构建出更强大、更灵活的异构计算平台。这种“乐高积木式”的芯片设计方式,不仅可以突破传统摩尔定律的物理极限,也为定制化芯片提供了更大的灵活性。

下一代数据中心设计:效率最大化

直流电源:随着AI工作负载对计算能力需求的激增,数据中心的功率密度也随之飙升,使得传统交流(AC)供电方式面临巨大挑战。现代AI机架的功率需求已从历史上的20千瓦跃升至2023年的36千瓦,预计到2027年将达到50千瓦 。英伟达甚至提出了600千瓦的机架架构 ,这使得传统的交流-直流多次转换带来的能量损耗变得不可接受。

因此,数据中心正转向采用直流(DC)电源,这是一种提升能效的新范式。直流配电可以消除多余的AC-DC转换步骤,从而减少能量损失并提高整体效率 。在600千瓦的AI机架中,即使是微小的效率提升,也能转化为巨大的能源节约。例如,以48V电压提供600千瓦功率将需要高达12500安培的电流,这在传统架构下难以实现 。

在此背景下,宽带隙(WBG)半导体材料如氮化镓(GaN)和碳化硅(SiC)变得至关重要。这些材料具有优异的电子迁移率、更高的击穿电压和更低的损耗,使其成为高频、高压电源转换系统的理想选择 。它们能够实现更高的功率密度,设计出更小、更轻的电源电子系统,并减少对散热的需求,直接解决了数据中心面临的“能源墙”挑战 。英伟达已在其高功率机架中采用意法半导体(ST)的SiC和GaN功率技术,以减少线缆体积并提高效率 。

液冷技术:现代数据中心正面临着日益严峻的散热挑战,散热已成为仅次于电力基础设施的第二大资本支出组成部分,也是最大的非IT运营支出。随着AI和HPC工作负载的爆发式增长,传统的风冷系统已难以满足需求,液冷技术正成为必然选择。

液冷市场预计将以14%的复合年增长率增长,到2029年将超过610亿美元 。液冷技术具有卓越的散热能力,水和介电液体每单位体积可吸收的热量是空气的数千倍,从而实现更紧凑、更高效的系统 。液冷能将冷却能耗降低高达90%,电力使用效率(PUE)接近1(甚至低至1.05),并可将数据中心物理占地面积减少多达60%,同时降低噪音 。

高性能AI芯片(包括GPU和定制ASIC)正在将热管理推向新的前沿,迫切需要先进的冷却解决方案 。例如,英伟达的GB200 NVL72系统明确设计为采用直接芯片液冷(DTC)技术,而谷歌、Meta、微软和AWS等主要超大规模云服务提供商也正在加速DTC冷却系统的部署 。

液冷技术主要包括以下几种类型:

直接芯片液冷(DTC):冷却液通过冷板直接接触芯片,分为单相和两相DTC。两相DTC通过冷却液的相变(液态到气态)吸收大量热量,效率更高 。

背板热交换器(RDHx):一种简单的提升冷却能力的方式,尤其适用于现有风冷环境中的热点区域,无需修改IT硬件 。

浸没式冷却(Immersion Cooling):将电子元件完全浸没在介电流体中,分为单相和两相。这种方法适用于极高密度或气流受限的环境,提供最大的热传递效率 。

为了确保液冷系统的最佳运行,需要部署多种传感器:

温度传感器:监测冷却液的进出口温度,以及数据中心内部(通道、机架、管道)的温度,以确保最佳热条件并防止热应力 。

压力传感器:监测冷却液压力,检测泄漏或堵塞,并确保最佳流量,从而最大限度地减少泵故障和意外停机 。

流量传感器:超声波流量计可提供冷却水系统的精确实时流量测量,从而实现效率、安全性和成本节约 。

冷却液质量传感器:油湿度和电导率传感器用于持续监测冷却液的降解、污染和水分含量,特别是对于浸没式冷却中的介电流体,提供早期预警以避免性能下降和设备损坏 。

当前,行业正处于一个“热临界点”,传统风冷对于高密度AI工作负载而言正变得过时,液冷已成为强制性转变,而非可选方案 。这意味着数据中心设计需要从根本上进行调整,以适应液冷的需求,包括强化地板、重新设计的电气系统以及针对功率密度而非占地面积优化的房地产选择 。

先进的热管理不仅涉及冷却硬件,还包括软件驱动的动态热管理(DTM)以及AI模型优化(如量化和剪枝),以降低计算强度和热负荷 。这种综合方法对于实现未来数据中心的效率最大化至关重要。

结语

展望未来,数据中心将呈现出日益异构化、专业化和能源高效的特点。芯片设计将超越传统的CPU/GPU范畴,向更细分的专用处理器发展;先进封装技术(如HBM、CPO)将成为提升系统性能的关键;而直流电源、液冷和全面的传感系统将共同构建下一代绿色、智能的数据中心。这场由AI驱动的硅基革命,要求整个半导体产业链持续创新,并加强战略合作,以共同塑造人工智能时代的数字未来。

免责声明:本网信息来自于互联网,目的在于传递更多信息,并不代表本网赞同其观点。其内容真实性、完整性不作任何保证或承诺。由用户投稿,经过编辑审核收录,不代表头部财经观点和立场。

证券投资市场有风险,投资需谨慎!请勿添加文章的手机号码、公众号等信息,谨防上当受骗!如若本网有任何内容侵犯您的权益,请及时联系我们。

相关文章

-

落地北京门店 京东放不下社区团购

2025-08-180阅读

-

银河通用世界人形机器人运动会夺冠,全自主操作遥遥领先,大秀落地硬实力

2025-08-180阅读

-

NVIDIA从未发布的Titan Ada:用的竟是6×8Pin转双16Pin!最高可达900W

2025-08-180阅读

-

全球亚军!宝安这个机器人太会跳了

2025-08-180阅读

-

绿动算力 超智融合

2025-08-180阅读

-

首届人形机器人运动会“全自主”“百米飞人”何以诞生?

2025-08-180阅读

-

世界人形机器人运动会|“冠军相”不只在赛场

2025-08-180阅读

-

每月一个稳定版:谷歌宣布 Android Studio 更新频率翻倍

2025-08-180阅读

-

让新兴职业更专业、更有发展、更受尊重 外卖平台宣布骑士保障激励体系升级

2025-08-180阅读

-

锚定新能源必争之地,五菱再攻10万元价格带

2025-08-180阅读